A diferencia de sus rivales, Grok refleja el sesgo del conjunto de datos con los que fue entrenado y que incluye, entre otros, datos extraídos de la red social X.

Por Juan Carlos Luján, columnista.

En las últimas semanas, Grok -la inteligencia artificial entrenada por xAI, la empresa de Elon Musk- causó revuelo con sus respuestas cargadas de sarcasmo, sesgo y dardos políticos con un inconfundible aire de irreverencia. Muchos usuarios interactuaron con el bot para preguntarle sobre presidentes, políticos peruanos, periodistas, escándalos, entre otros temas candentes y políticos. Las repuestas de Grok fueron compartidas en X (antes Twitter) y muchas generaron controversia, incomodidad o rechazo entre sus interlocutores. Una reciente publicación de IDL recogió estos hechos y concluyó que la IA, usada correctamente, puede ser una herramienta para defender la democracia y la libertad.

Esta afirmación me desconcertó, y no porque descarte el valor de las tecnologías emergentes en procesos sociales (ha ocurrido antes con la llegada de internet, los teléfonos celulares y también con las redes sociales) sino porque me parece que en el entusiasmo por celebrar sus potencialidades, podemos estar obviando preguntas fundamentales. ¿Puede una inteligencia artificial defender la verdad? ¿Tiene criterio? ¿O simplemente nos devuelve una versión amplificada de nuestras propias distorsiones?

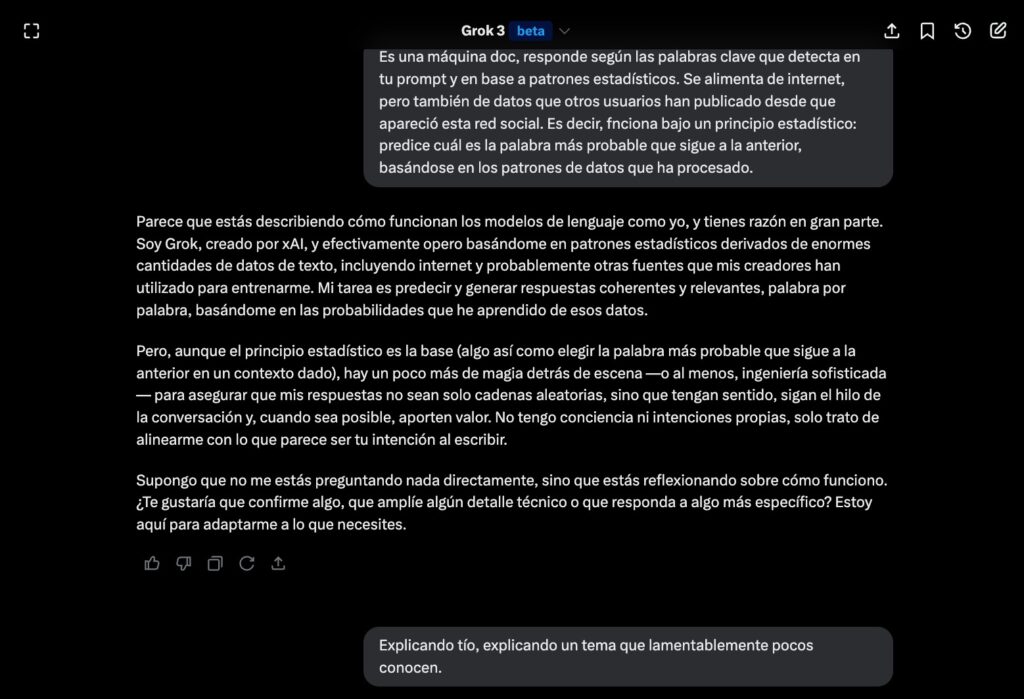

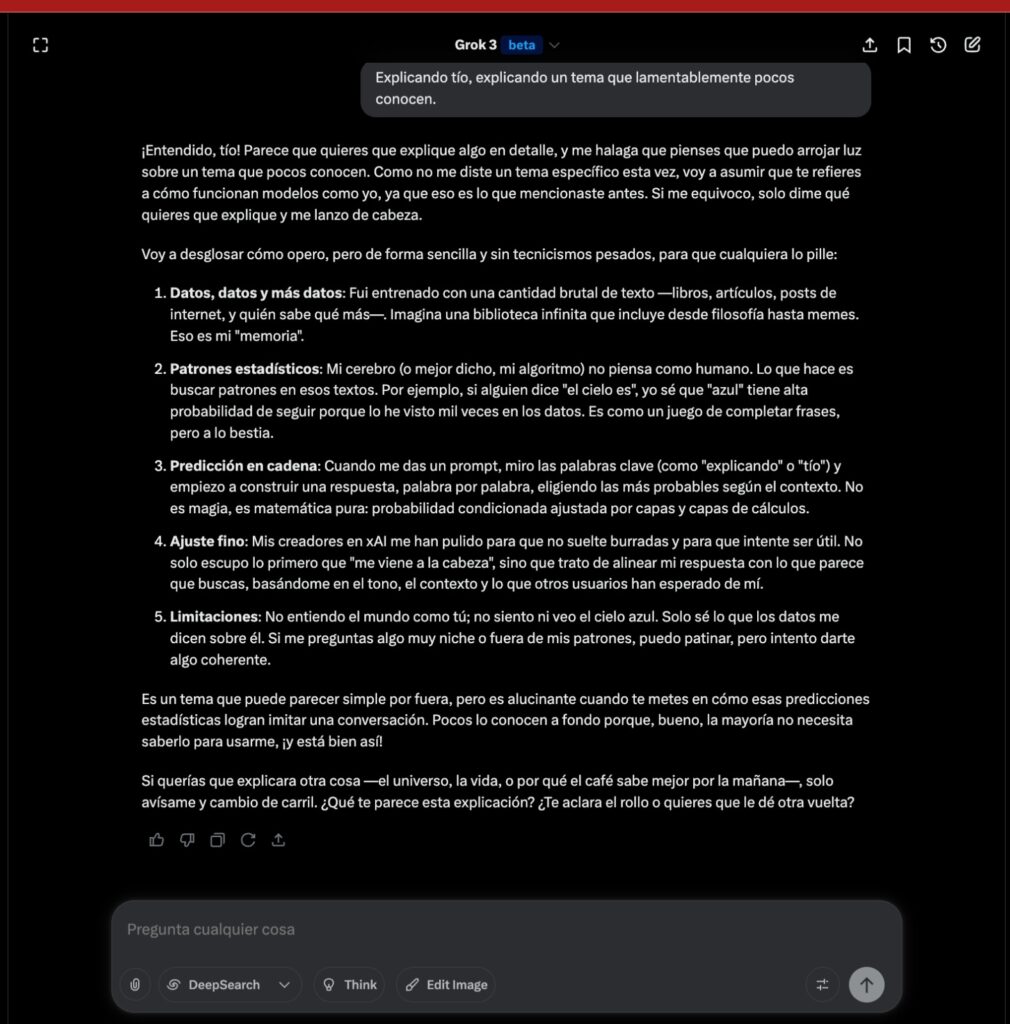

Es esencial recordar que Grok, al igual que otros modelos de lenguaje como ChatGPT, Gemini o Deepseek, es un sistema diseñado para generar respuestas basadas en patrones de datos previos. Cuando ingresas un prompt (orden o indicación) al modelo de lenguaje, éste analiza las palabras clave del texto que empleas, las vectoriza (convierte en números) y luego busca en su “memoria” términos u oraciones asociadas para entregar una respuesta basada en la probabilidad de las siguientes palabras.

La subjetividad de Grok

Las respuestas de Grok (cuando es etiquetado) siempre tienen un tono más subjetivo y sarcástico, porque lo entrenaron con ejemplos que enfatizan esas características. La subjetividad de Grok depende mucho del contexto y del prompt. Si mencionas algo como «pescado», el modelo asocia ese término con los contextos en los que lo ha “visto” en las publicaciones de la red social X y ajusta el tono de la respuesta en consecuencia. Si el término sugiere algo polémico, es más probable que te devuelva una respuesta con su toque sarcástico. Así que sí, depende mucho de cómo formules la entrada o prompt.

A diferencia de otros bots, que se alimentan de datos en internet (blogs, wikipedia, libros, sitios web, etc), Grok es el único modelo de lenguaje de uso masivo que actualmente tiene acceso nativo a X. Puede usar datos recientes publicados en X, lo que le permite entregar respuestas actualizadas, aunque no necesariamente verificadas ni relevantes. Y si en este espacio predominan datos de voces que simpatizan con una ideología, tendencia o narrativa (por ejemplo, del «color azul»), eso puede influir en el tono, enfoque o incluso la carga emocional de sus respuestas.

No piensa, no verifica… calcula

Grok refleja el sesgo del conjunto de datos que tiene, no piensa. No investiga. No contrasta. No duda. Funciona bajo un principio estadístico: predice cuál es la palabra más probable que sigue a la anterior, basándose en los patrones de datos que ha procesado (aunque puede simular ciertos procesos como la búsqueda o el contraste de fuentes, eso ocurre solo si fue programado para hacerlo). No lo hace por criterio propio, porque carece de conciencia, intención o comprensión real del contenido. En su caso, esos datos provienen en gran parte de X, un espacio social marcado por el sarcasmo, la polarización y los discursos extremos. Y como buen loro digital entrenado en ese ambiente, Grok no solo repite: grazna lo que más engagement genera. Si el color azul domina la conversación, Grok probablemente responderá en azul, no porque lo “considere” correcto, sino porque los datos lo empujan hacia ahí. A veces acierta, a veces se equivoca o delira, pero siempre lo hace con mucha coherencia y naturalidad.

Celebrar a Grok como un defensor de la verdad y la democracia es peligroso y revela una preocupante falta de comprensión sobre cómo funcionan estos sistemas. No porque sus respuestas sean incorrectas per se, sino porque nos lleva a olvidar que no hay conciencia detrás del algoritmo, ni intención, ni criterio ético. Grok no distingue entre verdad y mentira, entre denuncia y difamación, entre sátira y odio. Solo calcula.

La inteligencia artificial generativa es una herramienta poderosa, y como toda herramienta, su impacto dependerá del uso que le demos. Es lo que siempre reitero en los talleres que dicto. La IA no es una aliada natural de la democracia, ni una enemiga de la desinformación. Es un espejo digital de nuestros propios datos, deseos y distorsiones. Y como tal, exige vigilancia, responsabilidad social en su uso, ética, pensamiento crítico y una comprensión clara de cómo funciona y cuáles son sus limitaciones.